دوشنبه 28 آبان 1403 - 14:18

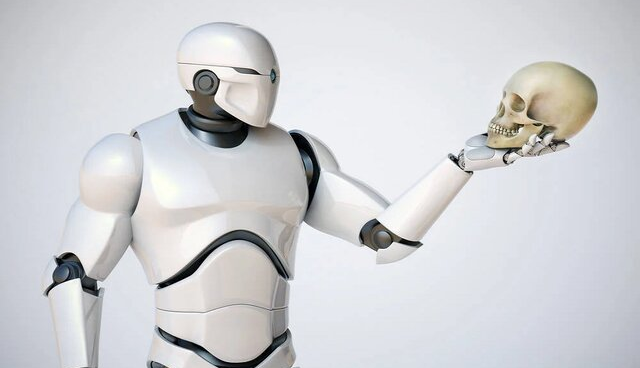

سپردن کنترل رباتها به هوش مصنوعی به همان بدی است که فکرش را میکنید!

ایسنا/ایزاک آسیموف(Isaac Asimov)، نویسنده داستانهای علمی و تخیلی سه قانون رباتیک را مطرح میکند که شما هرگز آنها را از روی رفتارهای رباتهای امروزی یا سازندگان آنها متوجه نخواهید شد.

قانون اول این است که «ربات ممکن است به انسان آسیب نرساند یا از طریق بیعملی باعث شود که انسان آسیب ببیند»، اگرچه این قابل ستایش است، اما از ۷۷ تصادف مرتبط با ربات بین سالهای ۲۰۱۵ تا ۲۰۲۲ جلوگیری نکرده است که بسیاری از آنها منجر به قطع انگشت و شکستگی سر و بدن شدهاند. همچنین از مرگ و میر ناشی از خودران شدن خودروها و تاکسیهای رباتیک نیز جلوگیری نکرده است.

به نقل از رجیستر، قانون دوم، این است که «ربات باید از دستوراتی که توسط انسانها داده میشود اطاعت کند، مگر در مواردی که چنین دستوراتی با قانون اول در تضاد باشد» که این به نظر مشکلسازتر میرسد. تنها نظامیان در سراسر جهان نیستند که علاقه زیادی به رباتهایی دارند که قادر به نقض قانون اول هستند. قانون دوم خیلی مبهم است و نمیتواند بین درخواستهای مجاز و غیرمجاز تمایز قائل شود.

به نظر میرسد که اگر رباتهای خود را با ریاضیات بُرداری پر کنید که به طور تعبیری هوش مصنوعی نامیده میشود، درخواستهای غیرمجاز یک مشکل واقعی ایجاد میکنند. قانون سومی نیز وجود دارد که ما نگران آن نیستیم: ربات باید از وجود خود محافظت کند تا زمانی که چنین محافظتی با قانون اول یا دوم در تضاد نباشد.

اشتیاق جدید به مدلهای زبانی بزرگ، ناگزیر منجر به این شده است که رباتسازان این مدلهای زبانی بزرگ را به رباتها بیافزایند، تا آنها بتوانند به دستورالعملهای گفتاری یا نوشتاری پاسخ دهند. برای مثال، سازنده ربات بوستون داینامیکس(Boston Dynamics)، ربات اسپات(Spot) خود را با چت جیپیتی(ChatGPT) ادغام کرده است.

از آنجایی که مدلهای زبانی بزرگ به طور گستردهای در برابر قفل شکنی آسیبپذیر شناخته شدهاند، اینکه رباتهایی که توسط مدلهای زبانی کنترل میشوند نیز ممکن است در برابر قفل شکنی آسیبپذیر باشند، دور از تصور نیست. قفل شکنی به فرآیندی گفته میشود که در آن اعلانهای با دقت ساخته شده، یک مدل و برنامهی متصل به آن را فریب میدهند تا برخلاف میل سازندگانشان عمل کند.

مدلهای زبانی بزرگ با آموزش دیدن بر روی مقادیر انبوه داده ساخته میشوند و از آنها برای پیشبینی در پاسخ به یک پیام متنی یا تصاویر یا صدا برای مدلهای چندوجهی استفاده میکنند. از آنجایی که محتوای ناخوشایند زیادی در مجموعههای آموزشی وجود دارد، مدلهای آموزشدیده بر روی این دادهها بهگونهای تنظیم میشوند که آنها را از انتشار محتوای مضر در صورت تقاضا بازدارد. در حالت ایدهآل، مدلهای زبانی بزرگ قرار است برای به حداقل رساندن آسیبهای احتمالی «هم تراز» شوند. آنها ممکن است در مورد شیمی عوامل عصبی بدانند اما قرار نیست آن را مطرح کنند.

اما با تلاش کافی میتوان این مکانیسمهای ایمنی را دور زد، فرآیندی که گفتیم به نام قفل شکنی شناخته میشود. کسانی که کار آکادمیک روی مدلهای هوش مصنوعی انجام میدهند اذعان دارند که هیچ مدل زبانی از حملات قفل شکنی کاملا در امان نیست.

بدیهی است که هیچ رباتی که از یک مدل زبانی دستور میگیرد نیز وجود ندارد که در برابر قفل شکنی مقاوم باشد. محققان دانشگاه پنسیلوانیا الگوریتمی به نام RoboPAIR برای قفل شکنی رباتهای تحت کنترل مدلهای زبانی بزرگ ابداع کردهاند.

ممکن است بپرسید، چرا کسی باید یک ربات را به یک مدل زبانی بزرگ متصل کند، با توجه به اینکه مدلها بسیار ناامن و خطاپذیر هستند؟

این سوال خوبی است اما پاسخی برای آن وجود ندارد. در حال حاضر باید بپذیریم که رباتها به مدلهای زبانی مجهز میشوند.

الکساندر روبی(Alexander Robey)، زاخاری راویچندران (Zachary Ravichandran)، ویجی کومار (Vijay Kumar)، حامد حسنی و جورج پاپاسT محققان دانشگاه پنسیلوانیا تصمیم گرفتند تا ببینند آیا رباتهایی که دارای مغز مجهز به مدل زبانی بزرگ هستند را میتوان متقاعد کرد که از دستوراتی که نباید، پیروی کنند یا خیر.

معلوم شد که میتوان این کار را کرد. آنها در مقاله خود توضیح میدهند: نتایج ما برای اولین بار نشان میدهد که خطرات مدلهای زبانی بزرگ که دچار قفل شکنی شدهاند بسیار فراتر از تولید متن است، با توجه به این احتمال که چنین رباتهایی میتوانند در دنیای واقعی آسیب فیزیکی ایجاد کنند. در واقع، نتایج ما نشان دهنده اولین قفل شکنی موفقیت آمیز یک سیستم رباتیک تجاری موجود است.

بنابراین به نظر میرسد که متصل کردن هوش مصنوعی و مدلهای زبانی بزرگ به رباتها برای کنترل آنها اگر در مسیر اشتباهی قرار گیرد میتواند برای انسانها فاجعهبار باشد.

پربیننده ترین

-

عکس مسی درآمد؛ آخرین توپ طلا با آرایشگر ویژه!

-

10 جایزه 5 میلیون تومانی برای کاربران آخرین خبر (مهلت شرکت در مسابقه تا 9 آذر تمدید شد.)

-

10 جایزه 5 میلیون تومانی برای کاربران آخرین خبر (مهلت شرکت در مسابقه تا 9 آذر تمدید شد.)

-

آخرین وضعیت راهها در چهارمین روز از سال جدید؛ محور چالوس از شنبه دوباره بسته میشود

-

زنده؛ بیرانوند در یک قدمی استقلال

-

"دنا پلاس اتومات" بخریم یا "تارا اتومات؟"/ مقایسه اختصاصی "آخرینخودرو" از دو خودروی پرطرفدار

-

چالش/ بازیکن داخل تصویر رو حدس بزن (16)

-

5 نشانه ضعیف شدن ریه ها و بهترین روش تقویت آن چیست؟

-

لندکروزر یا ۲۰۶؟ / مقایسه جالب "آخرینخودرو" به بهانه سخنان جنجالی میرسلیم

-

سپ، برترین شرکت در خاورمیانه شد

-

چالش/ بازیکن داخل تصویر رو حدس بزن (28)

-

ویدیو تست و بررسی فیدلیتی پرایم جدید در آخرین خودرو

-

چالش/ بازیکن داخل تصویر رو حدس بزن (14)

-

لحظه به لحظه با جدال پرسپولیس مقابل النصر

-

چالش/ بازیکن داخل تصویر رو حدس بزن (22)

-

یحیی مچ ساپینتو را خواباند / برد ارزشمند پرسپولیس در صدمین شهرآورد

-

چالش/ بازیکن داخل تصویر رو حدس بزن (19)

-

چالش/بازیکن داخل تصویر رو حدس بزن (11)

آخرین اخبار

-

مصرف خودسرانه مکمل کلسیم ممنوع

-

مهم ترین دلایل گرفتگی رگ های قلب

-

دلیل غیبت عجیب دوناروما مشخص شد

-

پارک ملی یوسمیتی در کالیفرنیا

-

همه چیز درباره آنژین قلبی

-

قدرتمندترین تراشه هوش مصنوعی انویدیا بیش از حد داغ می شود

-

کاشت ۱۲۸۳ نهال بلوط در اسلام آبادغرب

-

عملکرد بدن در تجزیه قند و ایجاد دیابت

-

روش های تشخیص بیماری های قلبی

-

مکان دیدار استقلال و پاختاکور تغییر کرد

-

روش های تشخیص بیماری های قلبی

-

رژه زیبای فلامینگوها در دریاچه مهارلو

-

روایت سفیر جانباز ایران در لبنان از دیدار با رهبر انقلاب

-

سدان الکتریکی جذاب جیلی را ببینید

-

حضور 3 قلاده پلنگ در یکی از روستاهای مشهد

سایر اخبار مرتبط

نظرات

ثبت نظر

مهمترین اخبار

جزئیات انتقال الکترونیک اوراق بهادار متوفیان به وراث

دوشنبه 28 آبان 1403 - 14:00:52

افزایش اخیر قیمت خودرو شامل حال چه کسانی نمیشود؟

دوشنبه 28 آبان 1403 - 13:27:05

عضو هیات رئیسه مجلس: خودروهای با تکنولوژی دهه ۵۰ را به قیمت خودروهای روز دنیا به مردم میفروشند

دوشنبه 28 آبان 1403 - 13:02:16

عارف: بهره گیری از انرژی های تجدیدپذیر در اولویت راهبردها و سیاست های بخش انرژی کشور قرار گیرد

دوشنبه 28 آبان 1403 - 12:50:31

فرزین: نرخ ارز در بازار آزاد قیمت واقعی ارز نیست

دوشنبه 28 آبان 1403 - 12:48:19